반응형

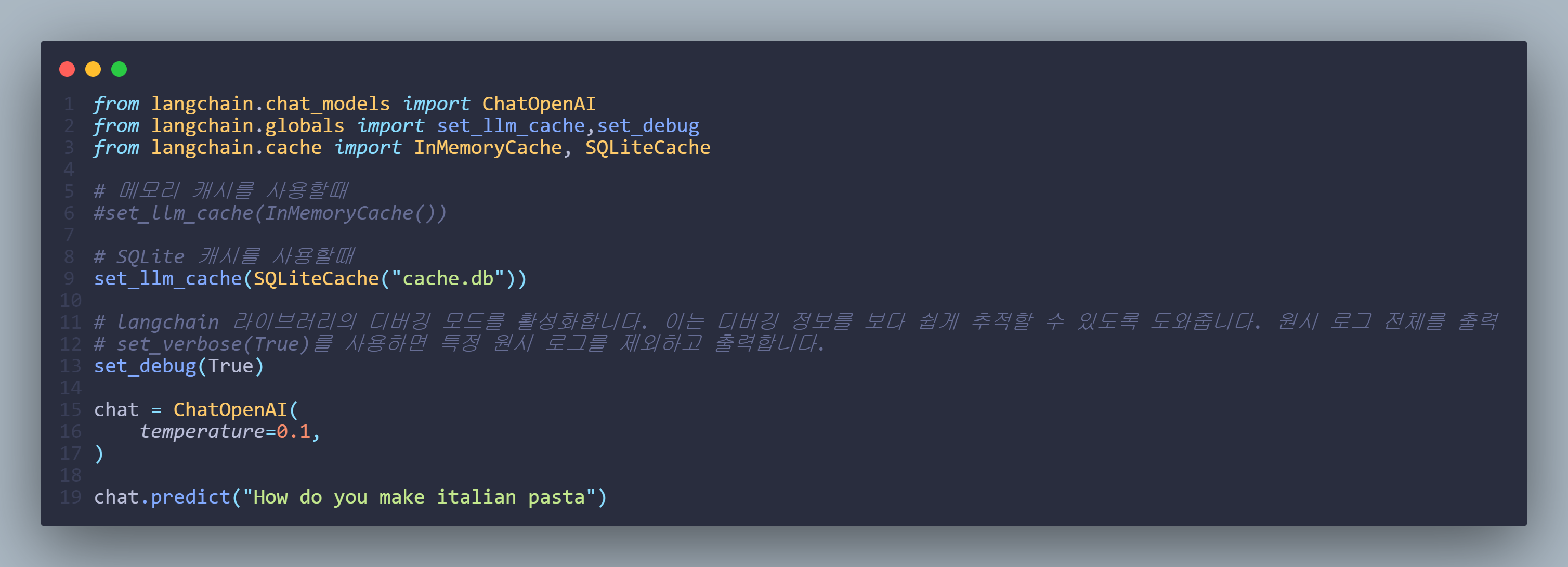

캐싱을 사용하면 언어모델의 응답을 저장할 수 있음

이후 동일 질문을 받을경우 언어모델에 질의를 하지 않고 캐싱된 답변을 가져옴

set_llm_cache

새 LLM 캐시 설정, 이전 값 덮어쓰기(있는 경우)

캐시 종류

InMemoryCache: 메모리를 이용하여 캐시를 저장. 서버 재실행시 캐싱된 내용이 사라짐

SQLite Cache: SQLite cache를 이용하여 캐시를 저장

그외에도 여러가지의 캐시가 있음

https://python.langchain.com/docs/integrations/llms/llm_caching#in-memory-cache

LLM Caching integrations | 🦜️🔗 Langchain

This notebook covers how to cache results of individual LLM calls using

python.langchain.com

set_debug(True): langchain 라이브러리의 디버깅 모드를 활성화합니다. 이는 디버깅 정보를 보다 쉽게 추적할 수 있도록 도와줍니다. 원시 로그 전체를 출력

set_verbose(True): 특정 원시 로그를 제외하고 출력

'python' 카테고리의 다른 글

| [GPT] ConversationBufferMemory (0) | 2024.03.29 |

|---|---|

| [GPT] get_openai_callback (0) | 2024.03.28 |

| [GPT] PipelinePromptTemplate (0) | 2024.03.28 |

| [GPT] 외부파일에서 prompt 가져오기 (0) | 2024.03.28 |

| [GPT] LengthBasedExampleSelector (0) | 2024.03.28 |